专栏名称: 视学算法

| 公众号专注于人工智能 | 机器学习 | 深度学习 | 计算机视觉 | 自然语言处理等前沿论文和基础程序设计等算法。地球不爆炸,算法不放假。 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

小众软件 · 开发者将开发了5年的项目开源,原因另外唏嘘· 2 天前 |

|

小众软件 · 94.5% 的人不知道的 ...· 5 天前 |

|

APPSO · 信通院:华为鸿蒙内核自主研发比率 ...· 2 天前 |

|

APPSO · iPhone 16 的更电池,或更容易更换· 5 天前 |

|

小众软件 · 酷产品:UniFi Express ...· 1 周前 |

推荐文章

|

小众软件 · 开发者将开发了5年的项目开源,原因另外唏嘘 2 天前 |

|

APPSO · iPhone 16 的更电池,或更容易更换 5 天前 |

|

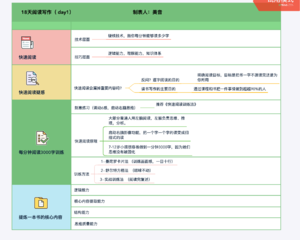

林小小猫 · 高效阅读,如何做到每分钟阅读3000字? 4 年前 |

|

高中学习帮 · 高中生物:蛋白质相关知识点总结 4 年前 |

|

湃客工坊 · 足疗少年“迷失”在嵩山 | 镜相 4 年前 |