专栏名称: 深蓝AI

| 专注于人工智能在线教育 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

科学家庭育儿 · 7岁前是黄金期!掌握这项技能的孩子,将来学习 ...· 4 天前 |

|

三个妈妈六个娃 · 在拥有了800多张小马宝莉卡后,老母亲终于搞懂了· 4 天前 |

|

世界音乐 · 一个饱受厌食症折磨的女人,用她的歌声治愈世界· 4 天前 |

|

常青藤爸爸 · 我退我的眼轴,你等你的论文,我们的娃都有光明的未来· 5 天前 |

|

常青藤爸爸 · 咱娃肯定用得上!商超品牌撤柜99.9元封顶· 6 天前 |

推荐文章

|

三个妈妈六个娃 · 在拥有了800多张小马宝莉卡后,老母亲终于搞懂了 4 天前 |

|

世界音乐 · 一个饱受厌食症折磨的女人,用她的歌声治愈世界 4 天前 |

|

常青藤爸爸 · 我退我的眼轴,你等你的论文,我们的娃都有光明的未来 5 天前 |

|

常青藤爸爸 · 咱娃肯定用得上!商超品牌撤柜99.9元封顶 6 天前 |

|

FDA食安云 · 十问十答!讲透团体标准 5 月前 |

|

i金山 · 金山这些企业招聘了,速戳→ 2 年前 |

|

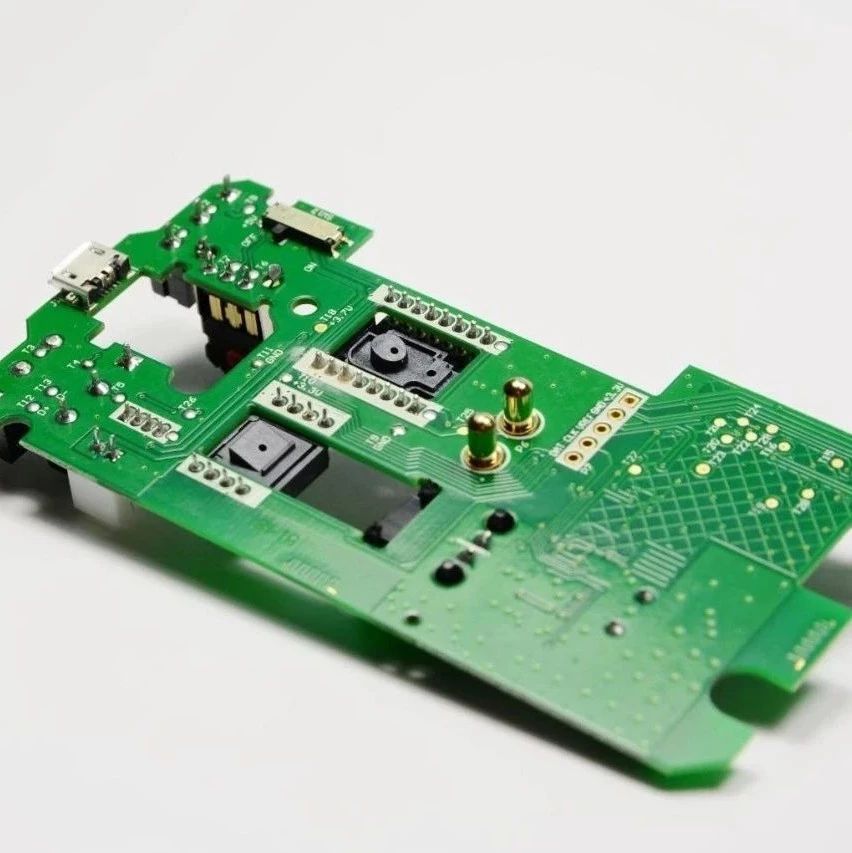

华秋商城 · 9月享9折!省钱备货才是“硬道理”! 4 年前 |