专栏名称: 机器学习研究组订阅

| 连接人工智能技术人才和产业人才的交流平台 |

今天看啥

公众号rss, 微信rss, 微信公众号rss订阅, 稳定的RSS源

目录

相关文章推荐

|

|

歸藏的AI工具箱 · 昨天跟乔木和 indigo 等朋友在 ... · 16 小时前 |

|

|

歸藏的AI工具箱 · 昨天跟乔木和 indigo 等朋友在 ... · 16 小时前 |

|

新智元 · 刚刚,Ilya官宣出任SSI ... · 2 天前 |

|

|

微信开发者 · 从用上到爱用,AI 代码助手经验分享 · 2 天前 |

|

|

微信开发者 · 从用上到爱用,AI 代码助手经验分享 · 2 天前 |

|

爱可可-爱生活 · 【[6星]AudioBERTScore:为文 ... · 2 天前 |

今天看啥

›

专栏

›

机器学习研究组订阅

CPU反超NPU,llama.cpp生成速度翻5倍!LLM端侧部署新范式T-MAC开源

机器学习研究组订阅 · 公众号 · AI · 2024-08-13 19:05

推荐文章

|

|

歸藏的AI工具箱 · 昨天跟乔木和 indigo 等朋友在 AGI Bar 见面聊了聊,朋友们很多发言都很有价值。 我主要聊了一下关于 AI 对于内容创作的影响以及如何培养流量嗅觉。 这里整理一下发出来: ### A.... 16 小时前 |

|

|

微信开发者 · 从用上到爱用,AI 代码助手经验分享 2 天前 |

|

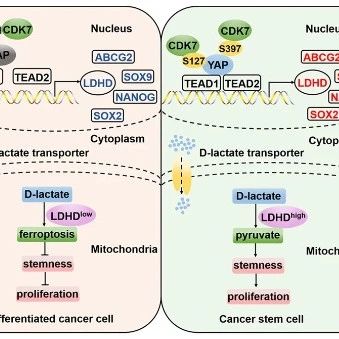

小张聊科研 · 国自然研究热点——肿瘤干细胞(下) 12 月前 |

|

专注业绩潜伏 · 股权激励超预期(9.3) 10 月前 |

|

姑苏晚报 · 凤凰传奇苏州演唱会重要提醒! 3 月前 |