专栏名称: 深度学习与NLP

| 专注深度学习、NLP相关技术、资讯,追求纯粹的技术,享受学习、分享的快乐。 |

今天看啥

公众号rss, 微信rss, 微信公众号rss订阅, 稳定的RSS源

目录

相关文章推荐

|

爱可可-爱生活 · [LG]《MDPO: Overcoming ... · 20 小时前 |

|

Jump x Switch · Switch ... · 昨天 |

|

Jump x Switch · Switch ... · 昨天 |

|

江苏药品监管 · 徐州检查分局三项举措推进化妆品生产企业主体责任落实 · 2 天前 |

|

江苏药品监管 · 徐州检查分局三项举措推进化妆品生产企业主体责任落实 · 2 天前 |

|

爱可可-爱生活 · 从简单加减乘除开始理解大型语言模型(LLM) ... · 2 天前 |

推荐文章

|

江苏药品监管 · 徐州检查分局三项举措推进化妆品生产企业主体责任落实 2 天前 |

|

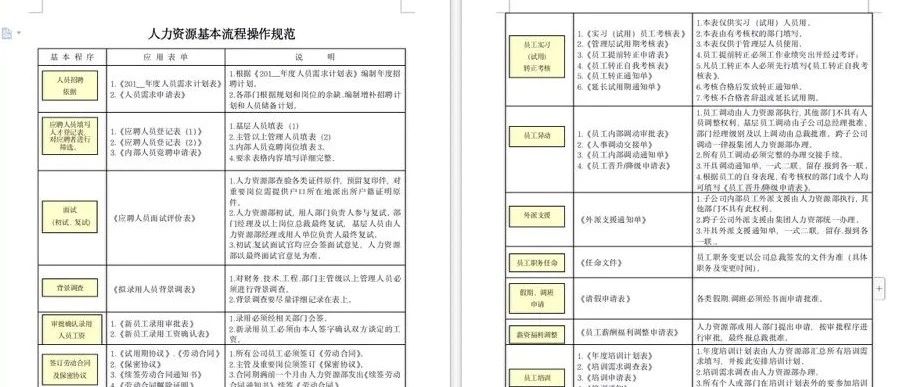

HR成长社 · 这哪是人事制度,简直就是宝典! 1 年前 |

|

四川省证券期货业协会 · 【金喜讲堂】近月合约和远月合约你了解吗? 11 月前 |

|

|

香港新港人 · 生活在香港 瑟瑟發抖! 3 月前 |