专栏名称: 大语言模型和具身智体及自动驾驶

| 讨论计算机视觉、深度学习和自动驾驶的技术发展和挑战 |

今天看啥

微信公众号rss订阅, 微信rss, 稳定的RSS源

目录

相关文章推荐

|

人民网舆情数据中心 · 如厕自由被《黄帝内经》管住?荒诞管理背后的逻 ... · 2 天前 |

推荐文章

|

鸭哥聊Java · 国企上班的必备技能。。。 9 月前 |

|

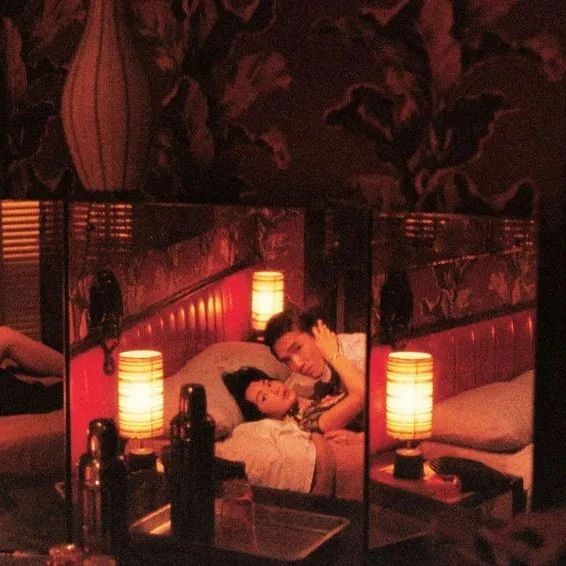

历史与秩序 · 北大知名女教授,她的电影课,学霸们排队两小时都要听! 5 月前 |

|

国际科学 · 研究发现:关于爱情与长寿,背后隐藏这么多秘密 3 月前 |